Durante los últimos 50 años, los métodos analíticos estándar han evolucionado desde XRF y espectroscopia de absorción atómica hasta análisis de activación de neutrones instrumentales, espectroscopia de emisión atómica ICP y espectroscopia de masas ICP. Ajustados a la inflación, los laboratorios de análisis comerciales ahora ofrecen análisis para la mitad de la tabla periódica con una precisión y límites de detección sorprendentes por el mismo precio que media docena de metales básicos realizados por la AAS hace 50 años.

La digestion en cuatro acidos con una combinación de ICP-AES e ICP-MS se está convirtiendo gradualmente en un estándar de la industria. Este es el paquete de ensayo más adecuado para empresas mineras y de exploración para análisis de rutina a un precio asequible. No es la mejor combinación analítica y de resumen para cada elemento, pero es la mejor técnica para la mayoría de los metales. ICP-MS también es un excelente método analítico para oligoelementos y es bastante adecuado para los elementos principales.

A pesar de que se están generando grandes cantidades de datos, la mayoría de las empresas todavía se limitan a trazar Cu, Au y algunos elementos traza, y no saben realmente qué hacer con los otros 50 elementos.

Tanto las empresas mineras como los laboratorios de análisis tienen estrictos protocolos QAQC para metales comerciales. Estos procedimientos incluyen la inserción de muestras de referencia con concentraciones de metales conocidas, la realización de ensayos duplicados y encuestas por turnos para comparar el rendimiento del laboratorio con otros laboratorios. No se aplican los mismos procedimientos de QAQC a todos los elementos reportados en los cuatro paquetes ICP AES e ICP MS de digestión ácida. Todos los laboratorios añaden un descargo de responsabilidad a los análisis mediante este método, advirtiendo que algunos metales pueden no disolverse completamente con una digestión de 4 ácidos. La realidad es que existe una diferencia significativa reportada por diferentes laboratorios para las mismas muestras. Todos los laboratorios utilizan los mismos instrumentos ICP AES y MS. Las diferencias en los resultados se deben a diferentes procedimientos de preparación de muestras y especialmente a diferentes protocolos de digestión ácida. La preparación de la muestra es de vital importancia, porque la mayoría de los metales que se disuelven tienen una solubilidad muy baja, por lo que sólo se puede utilizar una porción muy pequeña de polvo. Es de vital importancia utilizar procedimientos de trituración y molienda que homogeneicen la muestra lo más completamente posible para obtener análisis repetibles.

Sabemos que algunos metales no se disuelven totalmente en una digestión de 4 ácidos y, en algunas circunstancias, algunos metales no permanecen totalmente en la solución. Zr es el más obvio. En rocas más antiguas que tienen más daño por radiación en los cristales de circón, los análisis de Zr mediante ICP-MS con digestión en cuatro acidos suelen ser bastante cercanos al Zr total. Sin embargo, en rocas magmáticas jóvenes es común que ICP-MS con digestión en cuatro acidos reporte entre 20% y 50% del Zr total. El Cr mediante digestión en 4 ácidos ICP-MS suele ser del 50 al 75 % del Cr informado por XRF. También es común que el Al mediante ICP-MS con digestión ren cuatro acidos no se reporte entre un 5 y un 10 %. El grado en que muchos elementos se disuelven de forma incompleta se relaciona comúnmente con los tipos de alteración. Los elementos refractarios son más difíciles de disolver en rocas de facies de alteración ácida.

La mayoría de los geólogos desconocen por completo las diferencias entre los laboratorios de ensayo cuando se trata de análisis de ICP y simplemente suponen que todos los laboratorios son iguales. El punto a enfatizar aquí es que, si bien todos los laboratorios estarán configurados para informar datos de buena calidad para elementos calcófilos, por ejemplo, existen diferencias muy significativas en la calidad de los análisis para elementos más refractarios. Si intentamos utilizar estos elementos para caracterizar tipos de rocas y mapear procesos magmáticos, la calidad de los datos depende en gran medida de los protocolos de digestión que utilizan los laboratorios. Algunos laboratorios hacen esto muy bien. Muchos no lo hacen bien. La alternativa es utilizar una fusión de Li-borato, pero esto da como resultado límites de detección más altos y una precisión más baja. La mejor opción es encontrar un laboratorio que se especialice en realizar bien ICP-MS con digestión en cuatro acidos.

Si está interpretando datos geoquímicos, siempre que sea posible, regrese al núcleo de perforación. ¡Habrá aspectos de la interpretación que serán ambiguos pero que se resolverán fácilmente mirando las rocas!

Etiqueta: Geologia

-

Aprovechando al máximo la geoquímica multielemento. Un flujo de trabajo para interpretar los análisis ICP

-

Aplicación de modelo financiero en la comparación de depósitos minerales

El modelo financiero usa costos y variables relacionadas para estimar la recompensa económica de encontrar y desarrollar un depósito mineral. Para depósitos de mineral no descubiertos, se puede calcular el retorno económico potencial usando estimados razonables de minado y costos de capital, precio de venta de producto y reservas explotables. Al usar rangos razonables en los valores de estas variables, uno puede determinar la sensibilidad del retorno económico estimado en la inversión (ROI) Para las variaciones en estos factores. Combinando cualquier estimado subjetivo u objetivo de la probabilidad relativa de estas variaciones con el impacto de cualquier variación En el retorno económico genera el riesgo global del proyecto. La aplicación del procedimiento a proyectos alternativos permite la comparación de oportunidades de inversión que compiten por los recursos finitos del inversor. Aquí un modelo financiero típico es extendido, para un prospecto, para incluir consideraciones de probables variaciones sí tamaño o ley del depósito.

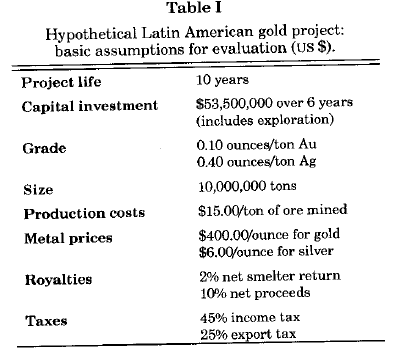

Usando un programa de computadora y modelamiento financiero comercial, interactive Financial planning system (IFPS), un modelo financiero fue construido de un depósito hipotético de oro hospedado en sedimentos es un particular país latinoamericano, para evitar tanto en la exploración de un depósito mineral y la negociación de un contrato equitativo de exploración y explotación. El modelo toma en cuenta la explotación existente y códigos comerciales, un tipo de yacimiento específico asumido con una distribución tonelaje ley único, y supuestos de costos razonables. El modelo apropiado de tonelaje ley fue obtenido de Mosier y otros (1992), y los costos de minado y capital fueron obtenidos del Mining Cost Service Handbook (Western Mine Engineering, 1987).

Los valores iniciales asumidos para las variables del modelo, ahora varios años desactualizados, están listados en la tabla 1. El modelo calcula en el ROI del proyecto, el tiempo para recuperar la inversión inicial (payback, retorno), la suma de impuestos y regalías para ser pagadas al gobierno, y el flujo de efectivo anual de la compañía. Para determinar la sensibilidad de estos resultados a las variaciones en los costos de minado, precio del oro y radio de regalías Es variado cada uno de estos componentes separadamente y calculados los índices financieros resultantes.

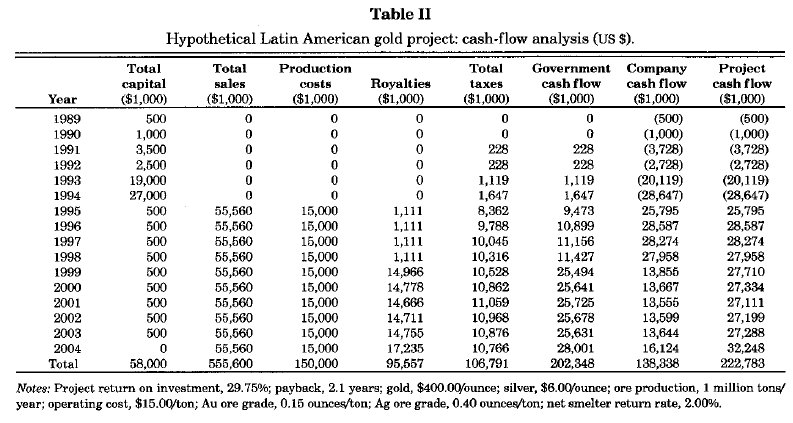

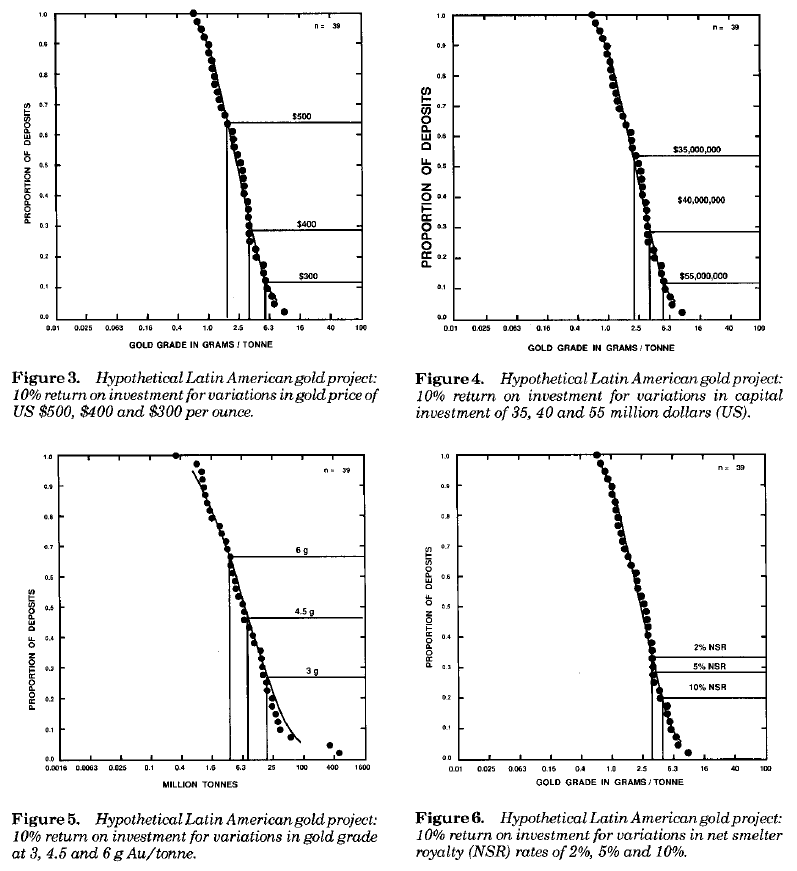

El impacto de las variaciones en esos factores en la vida de la mina, flujo de caja, payback y ROI son mostrados en la tabla 2. La sensibilidad del retorno financiero estimado a las variaciones en estos factores críticos es fácilmente demostrado por los simples gráficos. La figura 1 por ejemplo muestra cambios en el ROI como una función de cambios en el precio del oro. Aunque estos métodos documentan la sensibilidad del retorno económico a cambios en el los variables del modelo, no indica el impacto de la probabilidad cambiante de los del descubrimiento de depósitos de la suficiente medida y ley para producir un retorno adecuado.

El impacto de las variables financieras en el éxito de la exploración

Aunque muchos exploradores saben desde la experiencia que medida y ley del depósito generará suficientes retornos en la región donde ellos trabajaron estas líneas guía pueden no ser aplicables bajo las diferentes condiciones legales y económicas. Para ayudar a asegurar el deseado ratio de retorno, el modelo financiero fue usado para calcular la mínima ley y tamaño económico del depósito dando variaciones en los otros factores económicos.

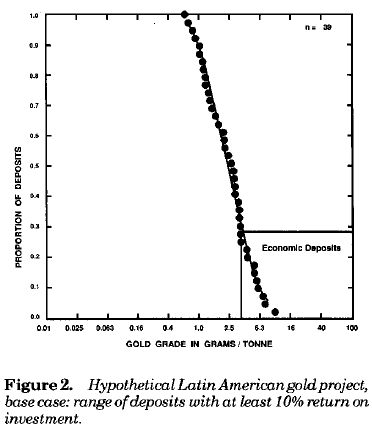

La figura 2 gráficamente despliega el rango aproximado de depósitos quedarían al menos un ROI de 10% para el caso base (Tabla I) en un plot de ley típico de un modelo típico ley-tonelaje.

Al hacer al tamaño del deposito una variable, podemos también usar estos resultados para estimar la probabilidad de descubrimiento de un depósito suficiente grande para garantizar la exploración y explotación bajo las condiciones económicas actuales o anticipadas. Un estimado independiente del número de depósitos no descubiertos en un área (basado en la experiencia de los exploradores en esta área) combinado con las probabilidades que un depósito descubierto es lo suficientemente grande para ser potencialmente económico (derivado de los gráficos tonelaje ley), se aproxima al riesgos de exploración.

Como es común en la mayoría de depósitos, el precio del oro tiene un impacto significativo en el número de depósitos que sean económicos. La magnitud de la inversión del capital y la ley mineral también tienen un efecto dramático en la economía de un prospecto. El alto precio, costo de capital bajo o ley alta de oro aumenta el número de depósitos que pueden retornar al menos un 10% de ROI a casi la mitad de los depósitos de oro hospedados en sedimentos conocidos en El Mundo. La suma de regalías tiene un efecto muy pequeño en el número de depósitos que probablemente retornen al menos 10% del ROI. Así, el potencial económico de un depósito de oro hipotético es menos sensible a los ratios de regalía y más sensible a los precios del oro, inversión de capital y ley.

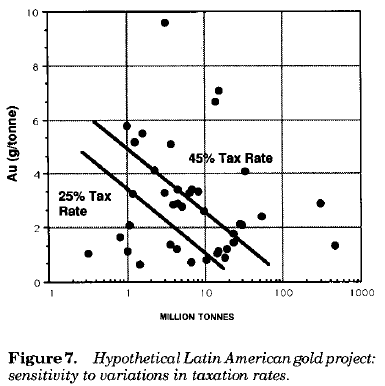

Otra forma de retratar los cambios en las variables económicas que afectan la viabilidad del proyecto es graficar el 10% del ROI para una variable dada en un diagrama de dispersión metal total contenido. Se muestra en la figura 7 los rangos de depósitos que tendrían al menos un 10% de ROI por radios de impuestos del 25 y 45%. Un número significativo de depósitos se vuelven económicamente potencial les en ratios bajos de impuestos. Se debe tener en cuenta el efecto dramático que las indemnizaciones por agotamiento y agendas de depreciación pueden tener un ratio de impuesto efectivo. El impacto de la variación en estas políticas de impuestos pueden ser modeladas de una forma similar. Los efectos de todas las clases de impuestos especiales que pueden afectar operaciones, como los impuestos de exportación, podrían también ser modeladas.

Sumario

Los efectos de las variaciones en los costos de minado, precios de resultados, ratios de impuestos, etc. En la probabilidad que hunde depósito de descubiertos sea económico en tamaño y medida puede ser fácilmente computados usando modelos financieros y pueden ser convenientemente desplegados en gráficos tonelaje ley un punto usado en conjunto con la geología de la región, las características tonelaje ley de tipos de depósitos específicos probablemente ocurran, estimados e independientes de la probabilidad de descubrir un número dado de depósitos, y un efecto de nivel de exploración dado, una estimación del riesgo de exploración puede ser obtenido. Esta rápida evaluación y técnica de comparación es especialmente útil en contrastar cambios en las leyes de minería e impuestos, seleccionando los mejores países para la exploración mineral, comparando oportunidades de exploración disponibles y predecir el éxito de un esfuerzo de exploración.Extraído y traducido de

G.E. McKelvey; Economic application of deposit models to mineral exploration – A rapid comparison technique -

Autoclaves: Una Revolución en la Lixiviación de Minerales

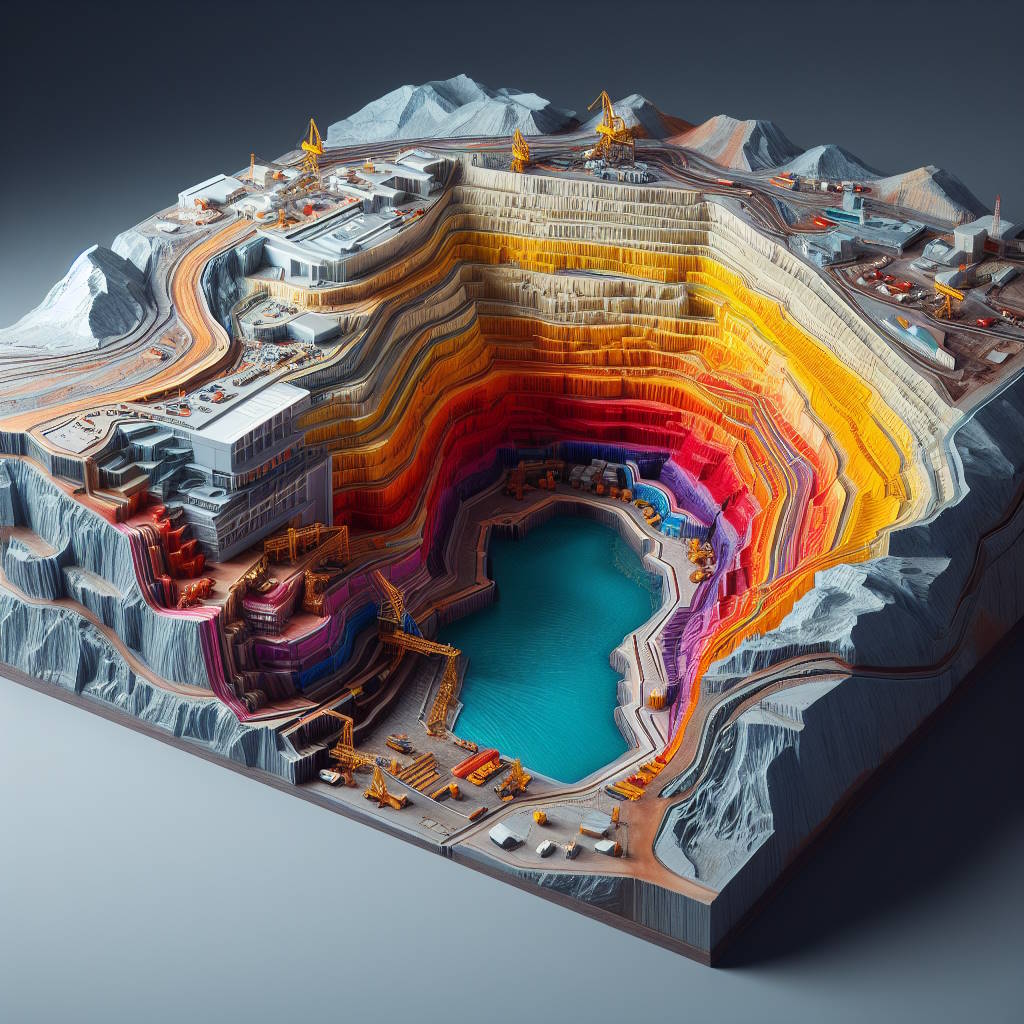

La lixiviación en autoclaves es un proceso crucial en la industria minera, utilizado para extraer metales valiosos de minerales y concentrados. Este método implica el uso de autoclaves, recipientes metálicos de paredes gruesas capaces de soportar altas presiones y temperaturas. A continuación, exploramos los aspectos más destacados y aplicaciones de la lixiviación en autoclaves.

¿Qué es un Autoclave?

Un autoclave es un equipo esencial en la industria, utilizado para realizar diversas reacciones industriales bajo condiciones controladas de alta presión y temperatura. La presión elevada en un autoclave permite que el agua alcance temperaturas superiores a su punto de ebullición, lo que es fundamental para la esterilización y otras aplicaciones industriales.

Lixiviación a Presión en Autoclaves

La lixiviación a presión en autoclaves se realiza para acelerar la disolución de metales y mejorar la eficiencia del proceso de extracción. Este método es especialmente útil para minerales que son difíciles de disolver bajo condiciones atmosféricas normales. Los autoclaves permiten mantener una alta concentración de reactivos gaseosos como el oxígeno, lo que aumenta la velocidad de disolución de los minerales.

Aplicaciones en Sulfuros de Cobre

La lixiviación de sulfuros de cobre, como la calcopirita y la bornita, es un ejemplo destacado del uso de autoclaves en la minería. Estos minerales son lixiviados en soluciones acuosas que contienen amoníaco, permitiendo una recuperación eficiente del cobre. Este proceso evita la necesidad de tratamientos preliminares como la tostación oxidante.

Ventajas de la Lixiviación en Autoclaves

- Mayor Eficiencia: Permite la disolución rápida de minerales difíciles.

- Control de Condiciones: Las altas presiones y temperaturas aceleran la reacción química.

- Menor Impacto Ambiental: Reduce la necesidad de procesos que generan emisiones contaminantes.

Estudios de Caso y Resultados Experimentales

En estudios experimentales, se ha observado que la adición de agentes tensoactivos como el quebracho puede mejorar significativamente la extracción de metales como el zinc y el cobre a altas temperaturas. Esto se debe a la reducción de la tensión superficial del medio acuoso, facilitando la difusión del oxígeno y la disolución del azufre elemental.

Conclusión

La lixiviación en autoclaves representa un avance significativo en la minería, ofreciendo un método más eficiente y ambientalmente responsable para la extracción de metales. Este proceso no solo mejora la recuperación de minerales valiosos sino que también optimiza los costos operativos, haciendo que la minería sea más sostenible y económica.

Referencias

- Encuentro Tecnología e Investigación – 32 Convención Minera

- Pressure Hydrometallurgy 2012 – Editors M.J. Collins, D. Filippou, J.R. Harlamovs, E. Peek

- Pressure Hydrometallurgy: A New Approach to Non-Polluting Processes

-

La anomalía del Atlántico Sur: la clave para una posible inversión geomagnética

La anomalía del Atlántico Sur es hoy en día una de las características más importantes del campo magnético de la Tierra. Su extensión en la superficie de la Tierra crece continuamente desde que se dispone de mediciones instrumentales de intensidad que cubren parte del hemisferio sur y se centran en América del Sur. Varios estudios asocian esta anomalía como un indicador de una próxima transición geomagnética, como una excursión o una inversión. En este artículo llevamos a cabo un estudio detallado sobre esta cuestión utilizando los modelos más recientes que también incluyen datos de la última misión Swarm de la ESA. Nuestros resultados revelan que uno de los parches de polaridad invertida ubicados en el CMB bajo el Océano Atlántico Sur está creciendo a una tasa pronunciada de −2,54·10 5 nT por siglo y con deriva hacia el oeste. Además, demostramos que el campo cuadrupolo controla principalmente este parche de inversión junto con la rápida decadencia del campo dipolar. La presencia de parches de inversión en el CMB parece ser característica durante la fase de preparación de una transición geomagnética. Sin embargo, el valor actual del momento dipolar (7,7 10 22 A·m 2 ) no es tan bajo en comparación con los datos paleomagnéticos recientes para el Holoceno (últimos 12 ka) y para toda la polaridad geomagnética normal de Brunhes (últimos ~0,8 Ma). , aunque la tasa de desintegración es similar a la dada por inversiones o excursiones geomagnéticas documentadas anteriormente.

Introducción

La dinámica del núcleo de la Tierra es un desafío hoy en día para la comunidad geofísica y el conocimiento detallado de la variación secular (SV) del campo magnético de la Tierra puede arrojar luz sobre este tema. Los datos geomagnéticos históricos ( Jonkers et al., 2003 ) están disponibles sólo desde el siglo XVI. Este es el caso de los datos direccionales (es decir, inclinación y declinación), pero no de los datos de intensidad porque Carl-Friedrich Gauss realizó las primeras mediciones de intensidad absoluta en 1832 ( Gauss, 1833 ). El uso de estos datos históricos ha permitido tener una imagen del comportamiento del campo geomagnético durante los últimos cuatro siglos tal y como refleja el primer modelo histórico publicado por Jackson et al. (2000) : el modelo GUFM1. A finales del siglo XIX, se establecieron observatorios geomagnéticos permanentes que proporcionaban series temporales continuas de datos geomagnéticos. Sólo a partir de mediados del siglo XX los datos geomagnéticos terrestres se complementaron con datos de satélite a diferentes altitudes sobre la superficie de la Tierra. La era de la medición por satélite comenzó con la anterior serie POGO, cuando en octubre de 1965 se lanzó el primer satélite, el OGO-2, para medir la intensidad total del campo geomagnético. La inclusión de los componentes vectoriales de las misiones satelitales (Magsat, Ørsted, CHAMP, SAC-C) ha proporcionado los modelos globales más precisos, como los modelos integrales de campo geomagnético ( Sabaka et al., 2015 y referencia allí, entre otros) . Desde finales de 2013 el esfuerzo por estudiar la evolución espacial y temporal del campo geomagnético experimenta una clara mejora gracias a una nueva misión de la Agencia Espacial Europea (ESA) ( Olsen y Haagmans, 2006 y referencias allí) dedicada específicamente a monitorear y estudiar el campo geomagnético. Complejidad del campo geomagnético actual: la constelación Swarm. La misión se basa en tres satélites gemelos que proporcionan mediciones de alta calidad del campo geomagnético en tres planos orbitales diferentes. Proporciona la posibilidad de obtener modelos “dinámicos” en tiempo real del campo geomagnético. Estos modelos sólo son posibles cuando tenemos mediciones simultáneas (a nivel del suelo y en el espacio) en diferentes emplazamientos, para separar con precisión las variaciones espaciales y temporales y explotar todo el potencial de la precisión con la que se puede medir el campo geomagnético en presente. Los últimos modelos globales que contienen los datos de Swarm son el IGRF-12 ( Thébault et al., 2015 ) o el CHAOS-5 ( Finlay et al., 2015 ), entre otros.

La Figura 1 muestra un mapa global del elemento de intensidad geomagnética en 2015.0 según los datos de Swarm (modelo proporcionado por el producto Level 2 Long-term de la ESA). Como se puede observar, existe una característica anómala sobresaliente que domina las características del campo total en la superficie de la Tierra: la llamada Anomalía del Atlántico Sur (SAA). Esta gran anomalía de la intensidad del campo geomagnético (aquí delimitada operativamente por la línea blanca de 32.000 nT) se extiende desde el Pacífico Oriental hasta Sudáfrica cubriendo latitudes entre 15 y 45°S con un valor mínimo alrededor de 22.500 nT ubicada cerca de la ciudad de Asunción ( Paraguay). Esta característica no sólo es característica del campo geomagnético actual sino que se ha presentado casi durante la era histórico-instrumental geomagnética, es decir, los últimos 400 años ( Jackson et al., 2000 ). Un estudio muy reciente ( Tarduno et al., 2015 ) analiza la antigüedad de esta anomalía mediante datos paleomagnéticos (de 1000 a 1600 d.C.) infiriendo la persistencia de la anomalía también durante esas antiguas épocas.

FIGURA 1. MAPA DE INTENSIDAD DEL CAMPO GEOMAGNÉTICO EN 2015.0 . Los valores de intensidad se generaron utilizando los coeficientes de Gauss del producto Swarm Level2 (modelo de campo MCO—L2 DCO Core). La región sobre la SAA (ver Figura 1 ) se caracteriza por una alta radiación cerca de la superficie de la Tierra debido al muy débil campo geomagnético local y, en consecuencia, representa la entrada favorita de partículas de alta energía en la magnetosfera, junto con la regiones polares ( Vernov et al., 1967 ; Heirtzler, 2002 ). Este efecto no sólo es problemático a gran altura, donde los satélites u otros objetos que orbitan alrededor de la Tierra se ven afectados por una alta densidad de partículas de rayos cósmicos, sino también a nivel de la superficie, donde las comunicaciones pueden verse perturbadas debido a las corrientes inducidas en la transmisión. líneas durante tormentas geomagnéticas ( Trivedi et al., 2005 ). Como ejemplo, la Estación Espacial Internacional requiere blindaje adicional para abordar este problema ( McFee, 1999 ) y el Telescopio Espacial Hubble interrumpe la adquisición de datos mientras pasa por el SAA. Además, la salud de los astronautas también se ve afectada por el aumento de la radiación en esta región, que se cree que es responsable de las peculiares «estrellas fugaces» que ocurren en su campo visual ( Casolino, 2003 ).

Gracias a los modelos geomagnéticos de alta resolución actuales conocemos el origen interior del SAA. El SAA en la superficie de la Tierra es la respuesta de una trayectoria de flujo inverso en el límite núcleo-manto (CMB) de la componente radial del campo geomagnético ubicado aproximadamente debajo del Océano Atlántico Sur generando la asimetría hemisférica del campo geomagnético (por ejemplo, Heirtzler , 2002 ). El comportamiento del SAA parece indicar que esta asimetría podría estar relacionada con la disminución general del campo dipolar y con el aumento significativo del campo no dipolar en la región del Atlántico Sur (p. ej., Gubbins et al., 2006 ; Aubert, 2015 ; Finlay et al., 2016 , entre otros).

Dado que el campo geomagnético cambia en el espacio y el tiempo y su fuerza dipolar magnética disminuye continuamente ( Thébault et al., 2015 ), el futuro de esta gran anomalía es un desafío de importancia teórica y práctica debido a los efectos de gran influencia sobre la salud humana y el impacto en la eficiencia instrumental. De hecho, la disminución de los valores de intensidad del SAA está lejos de ser un efecto regional, y los valores deprimidos del SAA cubren una gran área en el Océano Atlántico Sur y áreas adyacentes (Figura 1 ). Además, estudios muy recientes ( De Santis et al., 2013 ) indican que la extensión del área de la SAA sigue una aceleración logarítmica periódica que se asemeja al comportamiento de un sistema crítico que avanza hacia una transición crítica. Este comportamiento del campo geomagnético parece presente ya que se dispone de mediciones históricas o instrumentales del campo geomagnético. Otra característica interesante es que este bajo valor de la intensidad del campo geomagnético en latitudes bajas se complementa con un aumento en las regiones polares (como el caso de la llamada Alta Siberia) y este es el escenario clásico para una excursión o inversión del campo geomagnético.

La SAA durante los últimos 200 años

Para comprender mejor el comportamiento actual del SAA hemos realizado un estudio de la evolución espacial y temporal de este accidente geomagnético durante los últimos dos siglos.

Para el período más antiguo, utilizamos el modelo geomagnético histórico GUFM1 ( Jackson et al., 2000 ). Este modelo global fue desarrollado utilizando funciones armónicas esféricas (SH) en el espacio hasta el grado 14 y splines cúbicas en el tiempo, cubriendo el período de 1590 a 1990. Jackson et al. (2000) resolvieron la falta de información de intensidad antes de 1832 asumiendo una extrapolación lineal del primer coeficiente de Gauss.gramo01

antes de 1840 según su evolución durante las épocas más recientes, es decir, 1840-1990. Este coeficiente es una clave importante para estudiar el comportamiento del SAA ya que de él depende fuertemente el elemento de intensidad. En otras palabras, las intensidades del modelo GUFM1 no están bien restringidas antes de ~1840 y esto debe tenerse en cuenta cuando se calcula la extensión del área SAA. De hecho, si calculamos la extensión del área SAA siguiendo las nuevas versiones proporcionadas por Gubbins et al. (2006) y Finlay (2008) se encuentra una clara diferencia antes de 1840 (ver Figura 2 ) entre los diferentes modelos. Estos últimos autores desarrollaron los nuevos modelos utilizando todos los datos paleomagnéticos de intensidad disponibles ( Korte et al., 2005 ) desde 1590 hasta 1840 siguiendo diferentes enfoques y proporcionaron un nuevo valor para el primer coeficiente de Gauss para este período. Sin embargo, actualmente no se puede dar una respuesta definitiva sobre qué modelo es el mejor. Por esta razón, preferimos comenzar nuestro estudio después de 1840, dondegramo01

El coeficiente está bien restringido por datos de intensidad histórica/instrumental.

FIGURA 2. ÁREA DE EXTENSIÓN SAA SEGÚN DIFERENTES MODELOS HISTÓRICOS GLOBALES (VER LEYENDA) . De 1900 a 2015 utilizamos la última generación del Campo de Referencia Geomagnético Internacional, es decir, el IGRF-12 ( Thébault et al., 2015 ). Este modelo, propuesto cada 5 años por la Asociación Internacional de Geomagnetismo y Aeronomía (IAGA), proporciona una descripción global del campo geomagnético principal hasta el grado armónico 13 utilizando datos de satélites y de observatorios y estudios de todo el mundo. El IGRF-12 también contiene nuevos datos satelitales de alta calidad de la misión Swarm desde noviembre de 2013.

El uso de modelos globales para analizar el comportamiento de las SAA no es innovador y ya se han realizado algunos estudios utilizando el modelo GUFM1, como el trabajo de Hartmann y Pacca (2009) . Aplicaron el modelo GUFM1 junto con datos de cuatro observatorios geomagnéticos ubicados en América del Sur (Argentina y Brasil). Los resultados muestran que la SAA en la superficie de la Tierra se caracteriza por una deriva hacia el oeste-sur con tasas variables durante los últimos 400 años. Definieron la región SAA por la isolínea de intensidad de 28.000 nT y, según eso, la intensidad dentro de esta región está disminuyendo, como también lo corroboran los datos del observatorio. Finalmente, estos autores analizaron en la superficie terrestre la contribución no dipolar del modelo GUFM1 indicando que el SAA se rige por los términos cuadrupolar y octupolar. Un estudio más reciente ( De Santis y Qamili, 2010 ) modeló el SAA como la superposición del campo geomagnético axial y un monopolar equivalente local generado en la proximidad del CMB utilizando las predicciones del modelo GUFM1. Utilizando esta aproximación, caracterizaron el SAA como un “monopolo equivalente” que se mueve cerca del CMB con una deriva media de 10 a 20 km/año en una rotación anticiclónica centrada en 55°S de latitud y 0°E de longitud. De Santis et al. (2013) definieron la SAA en la superficie de la Tierra como la región limitada por la isolínea de intensidad de 32.000 nT y calcularon la extensión del área utilizando el modelo GUFM1. Los resultados de ese trabajo indican que la extensión del área de la SAA ha ido creciendo continuamente desde que hay datos geomagnéticos históricos o instrumentales disponibles (ver Figura 2 ).

En este estudio revisitamos el uso del modelo GUFM1 y, por primera vez, utilizamos el IGRF-12, ambos para analizar diferentes características de la SAA durante los últimos 200 años:

(a) Intensidad mínima del SAA en la superficie terrestre . Para ubicar la posición y el valor de la intensidad mínima dentro de la región SAA, hemos realizado un enfoque iterativo basado en el campo de gradiente de intensidad utilizando ambos modelos globales en pasos de 5 años desde 1840 hasta 2015. Las Figuras 3A , B muestran la movimiento y el valor de la intensidad mínima, respectivamente. La curva de intensidad mínima se caracteriza por una disminución continua con un SV medio de −30 nT/año. Por otro lado, como indican Hartmann y Pacca (2009) , el movimiento del SAA está directamente relacionado con la deriva hacia el oeste del campo geomagnético debido a la evolución del campo no dipolar. De hecho, la velocidad de la intensidad mínima de las últimas décadas concuerda bastante bien con la velocidad de la actual deriva hacia el oeste, es decir, ~0,18°/año ( Dumberry y Finlay, 2007 ).

(b) Extensión del área SAA en la superficie de la Tierra . Hemos calculado la extensión del área de la SAA utilizando ambos modelos. El área se ha calculado por interpolación en una cuadrícula regular sobre la superficie terrestre de 4 × 10 4 puntos. La región SAA estaba delimitada por la línea de contorno de intensidad de 32.000 nT. Nuestros resultados (ver Figura 4A ) concuerdan con los de De Santis et al. (2013) que muestran cómo la extensión del área SAA ha ido creciendo continuamente. Sin embargo, nuestros resultados revelan más detalles (ver Figura 4B ): la extensión del área SAA está aumentando con períodos de aceleraciones (1840–1875 y 1900–1960) y desaceleraciones (1975–1900 y 1960–2015). Para complementar este estudio, se proporciona como material complementario una animación que muestra la evolución de la SAA (cada 5 años) en términos de mapas de intensidad (Figura S1).

FIGURA 3. UBICACIÓN (A) Y VALORES (B) DE LA INTENSIDAD MÍNIMA DE 1840 A 2015 DADOS POR LOS MODELOS GUFM1 (PUNTOS ROJOS) Y EL IGRF-12 (PUNTOS AZULES)

FIGURA 4. ÁREA DE EXTENSIÓN DE SAA (A) Y SU PRIMERA DERIVADA TEMPORAL (B) DADA POR LOS MODELOS GUFM1 (PUNTOS ROJOS) E IGRF-12 (PUNTOS AZULES) El origen de la SAA: un estudio de caso de los últimos 200 años

Según Gubbins et al. (2006) la decadencia actual del campo geomagnético dipolo está relacionada con la extensión del área de la SAA. Sin embargo, este efecto debe considerarse a escala global porque el campo dipolar, que está definido por el grado armónico n = 1, tiene en cuenta las longitudes de onda espaciales más grandes. En otras palabras, la decadencia del campo dipolar aumenta el área de extensión del SAA y disminuye el campo de intensidad total promediado a escala global. Por otro lado, según otros estudios ( Hartmann y Pacca, 2009 ; De Santis et al., 2013 ), el comportamiento de los SAA durante los últimos siglos está relacionado con los grados armónicos superiores n = 2 y 3, es decir, los campos cuadrupolos y octupolos. Este es un tema importante porque estas contribuciones no dipolares juegan un papel importante durante las inversiones geomagnéticas que se caracterizan por altas proporciones entre la contribución no dipolar sobre la dipolar (por ejemplo, Valet et al., 1999 ).En este artículo hemos analizado con más detalle cómo ambas contribuciones, es decir, la dipolar ( n = 1) y la no dipolar ( n > 1), afectan a la evolución de la SAA durante los dos últimos siglos. Para ello, primero estudiamos el origen del SAA utilizando la componente radial del campo geomagnético proporcionada por los modelos GUM1 e IGRF-12. La Figura 5 muestra diferentes mapas de este elemento geomagnético en el CMB para cuatro épocas separadas desde 1840 hasta 2015. Como era de esperar, cuando se considera solo el campo dipolar (mapas A, B, C, D) el elemento B r presenta una clara simetría. en el CMB con valores positivos/negativos en el hemisferio geomagnético Sur/Norte. Sin embargo, la adición del cuadrupolo ( n = 2) al anterior rompe esta simetría justo debajo del Océano Atlántico Sur mostrando una clara anomalía en esta zona en el CMB (mapas E, F, G, H). Finalmente, cuando se incluye el octupolo ( n = 3) la simetría desaparece totalmente (mapas I, J, K, L) y aparece una región de polaridad de flujo inverso que se expande en el tiempo bajo el Océano Atlántico Sur convirtiéndose en un flujo inverso claro y aislado. polaridad en 2015 (Mapa L). Para complementar estos mapas, también hemos trazado los mapas de intensidad en la superficie de la Tierra para resaltar el efecto en el SAA utilizando las mismas contribuciones armónicas y épocas (consulte la Figura S2 del material complementario). Como muestran los diferentes mapas, el dipolo afecta los valores de intensidad a escala global mostrando valores bajos en los tiempos más recientes (decaimiento del campo dipolar, mapas A, B, C, D en la Figura S2). Por el contrario, los campos cuadrupolares y octupolares crean un claro camino de inversión en el CMB que genera valores de baja intensidad en la superficie de la Tierra centrada sobre el Océano Atlántico Sur y áreas adyacentes.

FIGURA 5. MAPAS DEL ELEMENTO RADIAL DEL CAMPO GEOMAGNÉTICO, BR, EN EL CMB PARA DIFERENTES ÉPOCAS Y DIFERENTES CONTRIBUCIONES ARMÓNICAS (VALORES DADOS POR LOS MODELOS GEOMAGNÉTICOS GLOBALES GUFM1 E IGRF-12). (A – D) Campo dipolo; (E – H) Campo dipolo + cuadrupolo; y (I – L) Campo dipolo + cuadrupolo + octupolo. El siguiente paso es calcular el área de extensión de SAA utilizando las diferentes contribuciones armónicas. El procedimiento para calcular el área de extensión SAA es el detallado en la Sección anterior Extensión del Área SAA en la Superficie Terrestre. La diferencia radica en los valores de los coeficientes de Gauss involucrados en los primeros tres grados armónicos. Hemos mantenido constante el valor del coeficiente de Gauss al inicio de las ventanas temporales, es decir, en 1840. La Figura 6 muestra los resultados de las diferentes áreas de extensión de SAA según las diferentes contribuciones armónicas constantes. La línea negra es el área de extensión SAA original cuando se modifica cualquier coeficiente de Gauss (igual al de la Figura 4A ). El efecto cuantitativo en el área de extensión SAA debido a un dipolo constante (línea roja) o cuadrupolo (línea azul) es aproximadamente el mismo con una reducción del área alrededor de un 50 % más pequeña que la original para la ventana temporal total. Este porcentaje aumenta hasta el 85% cuando consideramos ambas aportaciones juntas (línea amarilla). Finalmente, una contribución octupolar constante no afecta significativamente el área de extensión (línea verde), pero cuando esto se suma al dipolo y cuadrupolo constantes anteriores, el área de extensión SAA no presenta cambios importantes durante los últimos 200 años (línea violeta).

FIGURA 6. ÁREA DE EXTENSIÓN DEL SAA MANTENIENDO CONSTANTES ALGUNAS CONTRIBUCIONES ARMÓNICAS EN 1840, ES DECIR, LA ÉPOCA INICIAL DE LA MEDICIÓN DE INTENSIDAD INSTRUMENTAL . El área de extensión la proporciona la isolínea de intensidad de 32.000 nT en la superficie de la Tierra mediante los modelos GUFM1 e IGRF-12. Discusión

La última inversión completa del campo magnético de la Tierra ocurrió hace 780.000 años: la inversión de polaridad Matuyama-Bruhnes (M-B), donde el polo norte magnético se desplazó hacia el polo geográfico sur alcanzando la polaridad normal actual. Esta característica ha sido profundamente estudiada hasta convertirse en el evento geomagnético pasado mejor documentado en base a la enorme densidad de datos paleomagnéticos que registran esta transición de polaridad (ver Valet et al., 1999 para una revisión). Durante la última década, estos datos paleomagnéticos se han utilizado para modelar el comportamiento del campo geomagnético durante esta transición ( Leonhardt y Fabian, 2007 ) o para limitar las simulaciones numéricas de geodinamo (por ejemplo, Aubert et al., 2008 ) señalando diferentes escenarios. para la fase precedente de una inversión geomagnética.

Una de las hipótesis más aceptadas es que las transiciones geomagnéticas están precedidas por la aparición de parches de flujo de polaridad invertida en latitudes bajas o medias que luego migran hacia los polos reduciendo el campo dipolar axial ( Aubert et al., 2008 ; Wicht y Christensen, 2010 ; entre otros). De hecho, durante una inversión, la fuerza dipolar (momento dipolar geomagnético, DM) decae hasta valores entre un 10 y un 20% inferiores a los característicos de un cron geomagnético (véanse las curvas DM proporcionadas por Valet et al., 2005 ; o Channel et otros, 2009 ). Al mismo tiempo, las contribuciones no dipolares desempeñan un papel importante, como lo pone de relieve la diversidad en las trayectorias de los polos geomagnéticos virtuales encontradas en estudios paleomagnéticos centrados en el mismo evento geomagnético (ver, por ejemplo, Laj et al., 2006, donde Laschamp Se analiza la excursión geomagnética).

De acuerdo con los patrones antes mencionados, se podría pensar que el actual campo geomagnético está pasando a una transición porque: (a) lo caracterizan un aumento de las contribuciones no dipolares y una conocida decadencia del campo dipolar; (b) dos parches prominentes de polaridad inversa se encuentran en el CMB en la parte sur de América y África; (c) cálculos estadísticos simples muestran que el tiempo promedio entre reversiones es de 400 kaño y la última reversión ocurrió hace 780 kaño.

Para analizar con más detalle al menos los dos primeros patrones anteriores, hemos utilizado los modelos geomagnéticos GUFM1 e IGRF-12 de 1840 a 2015.

La Figura 7 contiene la energía de los campos dipolar y no dipolar, en términos de los espectros de potencia de los coeficientes de Gauss en la superficie de la Tierra, para ambos modelos desde el inicio de las mediciones instrumentales del elemento de intensidad, es decir, 1840. Resultados muestran que el campo dipolar está disminuyendo a una tasa de −12% por siglo y esta tasa es más rápida de lo esperado para la difusión geomagnética y concuerda con las tasas de desintegración encontradas en las transiciones geomagnéticas ( Laj y Kissel, 2015 ). Además, la energía del campo no dipolar aumenta con el tiempo a un ritmo pronunciado del +70% por siglo.

FIGURA 7. ENERGÍA, EN TÉRMINOS DE ESPECTROS ESPACIALES DE POTENCIA, DEL VALOR CUADRÁTICO MEDIO, DEL CAMPO DIPOLAR (EJE VERTICAL IZQUIERDO Y PUNTOS AZULES) Y DEL CAMPO NO DIPOLAR (EJE VERTICAL DERECHO Y PUNTOS ROJOS) EN LA SUPERFICIE DE LA TIERRA PARA EL ÚLTIMOS 200 AÑOS SEGÚN LOS MODELOS GUFM1 E IGRF-12 . El campo no dipolar viene dado por las contribuciones armónicas del 2 al 6. Sin embargo, el escenario anterior parece estar alejado de los que caracterizan una transición geomagnética, porque el valor actual del DM no parece ser anómalo si lo comparamos con el DM durante el Holoceno (últimos 12 ka) y la cronología completa de la polaridad de Brunhes. (últimos 0,78 ka). Para el primer caso, es decir, el Holoceno, hemos utilizado el modelo global SHA.DIF.14k ( Pavón-Carrasco et al., 2014 ). Como se indica en la Figura 8A , durante el Holoceno la DM oscila entre 4 y 11 × 10 22 A·m 2 con un valor medio igual a 8,1 ± 1,6 × 10 22 A·m 2 . Para tiempos más antiguos, utilizamos las curvas SINT800 ( Guyodo y Valet, 1999 ) y PISO-1500 ( Channel et al., 2009 ) que proporcionan el DM (en este caso es el momento dipolar axial virtual) para los últimos 800 ka y 1,5 Ma, respectivamente. Ambas curvas muestran los valores de DM durante las transiciones geomagnéticas: 7 excursiones (flechas rosadas en la Figura 8B ) y la inversión B-M (flecha verde en la Figura 8B ). Como se muestra, los valores de DM para estos eventos son bajos con valores alrededor de 3 × 10 22 A·m 2 para la excursión y menores que 1 × 10 22 A·m 2 para la inversión de BM. El DM promedio para todo el cron es 6.0 ± 1.5 × 10 22 y 7.1 ± 2.7 × 10 22 A·m 2 considerando SIN800 y PISO-1500, respectivamente.

FIGURA 8. (A) Momento dipolar y error en 2σ (curva azul) según el modelo SHA.DIF.14k para los últimos 12 ka.

(B) Momento dipolar axial virtual dado por las curvas paleomagnéticas SINT800 (curva roja con error en 1σ) y PISO-1500 (curva amarilla con error en 1σ) para los últimos 900 ka. Las flechas rosadas corresponden a excursiones geomagnéticas y la flecha verde a la transición B-M. Las líneas horizontales negras muestran el valor del momento dipolar en 2015,0 dado por el producto de Nivel2 de Swarm.La comparación con el valor actual del DM (7,7 10 22 A·m 2 , proporcionado por los productos Swarm Level2 en 2015.0) muestra que incluso si el campo dipolar está decayendo durante los últimos siglos, el valor del DM concuerda con la media valor de la MS durante el Holoceno y es superior a los valores típicos de MS durante las excursiones (~3 × 10 22 A·m 2 ) y la inversión de BM (inferior a 1 × 10 22 A·m 2 ).

En términos de parches de polaridad inversa en el CMB, hemos analizado el componente radial en el CMB (solo hasta el grado armónico 6) utilizando los modelos geomagnéticos de 1840 a 2015 (ver Figura 9 ). Al comienzo de nuestras ventanas temporales, solo hay un parche de polaridad inversa en el CMB que cubre la mayor parte del Océano Atlántico Sur (Figura 9A ). Este parche se movió hacia el oeste, creció en extensión y luego, alrededor de 1900, se dividió en dos parches diferentes (Figuras 9B a D ; consulte la serie de mapas cada 5 años en la Figura S3 del Material complementario). A partir de este momento, la extensión del área de la mancha de flujo inverso ubicada en América del Sur (con el centro cerca de las Islas Malvinas) se mantiene constante durante los últimos 115 años, sin embargo, la otra mancha ubicada en el océano Atlántico entre África y la Antártida se convierte en más acentuado y con clara deriva occidental. Sin embargo, queremos advertir que este comportamiento antes de 1900 (es decir, un parche de inversión) podría no ser real debido a la menor resolución del modelo GUFM1 en comparación con el modelo IGRF-12. Este estudio se complementa con el comportamiento de los valores mínimos del elemento radial geomagnético B r para ambos parches de inversión (ver Figura 9E ). El valor mínimo de B r para la zona africana está disminuyendo a una tasa de −2,54·10 5 nT por siglo, lo que provoca el crecimiento del área de esta zona en el CMB. Por el contrario, el parche americano parece estar desapareciendo ya que el valor mínimo de B r presenta una tasa de cambio positiva: +0,67·10 5 nT por siglo.

FIGURA 9. ELEMENTO RADIAL BR DEL CAMPO GEOMAGNÉTICO EN EL CMB EN (A) 1840, (B) 1900, (C) 1950 Y (D) 2015. (E) Evolución temporal del mínimo del campo radial en el CMB para cada parche de reversión desde 1900 hasta 2015. Los parches encontrados parecen estar de acuerdo con la hipótesis revisada recientemente por Tarduno et al. (2015), donde los autores sugieren que la aparición de estos parches de polaridad inversa está relacionada con los límites de la gran provincia africana de baja velocidad de corte (LLSVP). El LLSVP es un área abrupta en el CMB bajo Sudáfrica caracterizada por una anomalía de ondas sísmicas bajas. Tarduño et al. (2015) proponen que el flujo central en áreas cercanas al LLSVP africano desarrolla un componente ascendente a pequeñas escalas, lo que permite que haces de flujo de polaridad invertida se filtren hacia arriba, pero también admiten que se necesitan simulaciones teóricas y numéricas más detalladas para confirmar su hipótesis.

Finalmente, en términos estadísticos, la ocurrencia promedio de transición geomagnética durante los últimos 83 Ma es de 400 kaño ( De Santis et al., 2013 ). Calcularon el valor medio sólo para los últimos 83 Ma para evitar el Supercrono Normal del Cretácico (de 83 a 121 Ma), donde el campo geomagnético mantuvo la misma polaridad normal durante 38 Ma.año. Si tenemos en cuenta que la última inversión se produjo hace 780 ka, este sencillo estudio estadístico sugiere que el campo geomagnético está tardando mucho en alcanzar una nueva inversión, superior al valor medio de 400 kaño. Sin embargo, también señalamos que Constable y Korte (2006) han demostrado que la probabilidad de observar un cron tan largo como el actual Brunhes chron no es improbable.

Volviendo a las tres características de una inversión, es decir, (a) campo dipolar de desintegración, (b) parches de inversión en el CMB en latitudes medias y (c) una tasa media de 400 kaño para las inversiones, podemos concluir que los patrones (b) y (c) concuerdan con una próxima transición del campo magnético de la Tierra. Sin embargo, el primero (a) no está claro: aunque el campo dipolar decae más rápido de lo esperado por la difusión geomagnética, el valor actual del DM no es comparable con los dados por las transiciones geomagnéticas registradas en las rocas. Sin embargo, es interesante observar que el ritmo actual de decadencia es comparable al ocurrido durante reversiones anteriores ( Laj y Kissel, 2015 ).

Conclusiones

En este trabajo hemos analizado en detalle los pros y los contras de una posible transición geomagnética próxima, prestando especial atención al continuo aumento del área de extensión SAA. Nuestros resultados, realizados durante los últimos 200 años, revelan que el campo geomagnético presenta dos parches de polaridad inversa en el CMB que están creciendo y moviéndose hacia el oeste. Ambas zonas se caracterizan por valores negativos de la componente radial del campo geomagnético y la zona africana está creciendo a una tasa de −2,54·10 5 nT por siglo. Además, hemos demostrado que el campo cuadrupolo controla principalmente estos parches de inversión en el CMB y esto concuerda con la fase previa de una transición geomagnética. Sin embargo, el DM obtenido no es tan bajo si se compara con datos paleomagnéticos recientes para el Holoceno y con el valor medio de DM para toda la polaridad geomagnética de Brunhes (último ~0,8 Ma), y esto es una clave importante en la fase de preparación de una inminente transición geomagnética. La nueva misión Swarm está proporcionando más datos geomagnéticos nuevos y de alta calidad que pueden arrojar luz sobre este desafío, porque el seguimiento continuo del reciente SAA es fundamental para comprender las próximas direcciones del campo geomagnético.

Fuente: https://www. frontiersin.org/articles/10.3389/feart.2016.00040/full

-

Modelo de bloques en Surpac, Vulcan, Minesight y Micromine.

SURPAC

Los modelos estándar de Surpac se identifican por su sufijo: *.mdl. Un formato de modelo de bloque secundario de Surpac es el «modelo de bloque libre», identificado por el sufijo *.fbm.

En otras palabras, Surpac utiliza el método de subdivisión de octree. un método regular de subbloqueo, de modo que los bloques principales deben dividirse en fracciones de 1⁄2n, es decir, 1⁄2, 1⁄4, 1⁄8, etc. El subbloqueo se define cuando se crea el modelo. Sin embargo, la división real de bloques no se realiza hasta que es necesaria. Esto significa que el número de bloques es siempre el mínimo posible.

Surpac también tiene el concepto de “superbloque” donde se aglomeran bloques idénticos hasta que ya no se puede realizar más aglomeración; esto significa que el tamaño del modelo almacenado de un modelo de bloques de Surpac puede ser mucho más pequeño que el de un modelo de bloques de Datamine.Los diferentes regímenes de tamaño de subceldas significan que muchos modelos de Datamine no se pueden convertir a un modelo de bloque Surpac nativo (mdl) si hay subceldas irregulares. Surpac proporciona el formato de “modelo de bloques libre” para importar y manipular modelos de bloques de Datamine en Surpac

Si se le proporciona un modelo de bloque “.fbm”, es mejor volver a la fuente y ver si se puede obtener el modelo de bloque original de Datamine “.dm”, o si tiene acceso a Surpac, se puede exportar como un archivo “.dm”. De lo contrario, organice una exportación de los datos en formato “.csv” y conviértalos en Deswik a un modelo de Datamine. Sin embargo, lo que se puede hacer con estos modelos es limitado. Tenga en cuenta que los campos de Surpac también pueden ser del tipo «Calcular». Este tipo de campo solo se calcula cuando se utiliza el campo, mediante una ecuación que completa la columna de descripción del campo.

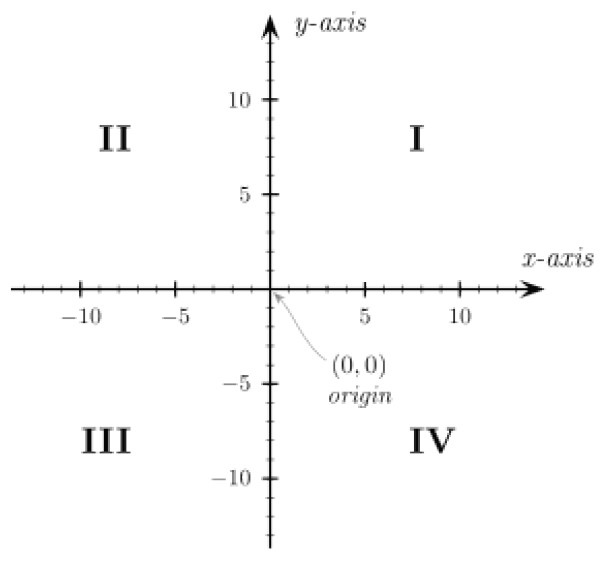

Al convertir un modelo Surpac, tenga en cuenta que Surpac permite construir modelos en cualquiera de los cuatro cuadrantes cartesianos (I, II, III y IV), como se muestra en la Figura

VULCAN

Los modelos de bloques de Vulcan se pueden identificar mediante el sufijo de extensión de archivo *.bmf. También puede haber un archivo *.bdf asociado, que es un archivo de definición de bloque (utilizado en la creación del modelo de bloques, pero no necesario una vez que se ha creado el modelo de bloques).

Existen varias versiones del modelo de bloques Vulcan.

El formato original del modelo de bloques de Vulcan (Clásico) almacenaba todos los datos de todos los bloques. Esto significaba que si tenía un millón de bloques con el valor predeterminado, su archivo de modelo de bloques había escrito el valor predeterminado un millón de veces. Esto resultó en un archivo de modelo muy grande.

El formato «Extendido» escribe toda la información predeterminada en el encabezado y luego hace referencia al encabezado para cualquier bloque con valores predeterminados. Esto significa que el archivo del modelo de bloques escribirá este valor en el encabezado una vez (no un millón de veces) si tiene un millón de bloques con el valor predeterminado en el formato «Extendido». Este método ahorra una cantidad significativa de espacio en archivos.MINESIGHT

Un modelo de bloques MineSight generalmente tendrá el sufijo *.dat

(Los archivos de modelo de bloques de Micromine también utilizan el sufijo *.dat). Tenga en cuenta que MineSight también utiliza el sufijo *.dat para otros tipos de archivos, como datos sin procesar de pozos de perforación y archivos de control de proyectos.

Otros tipos de archivos de MineSight incluyen:» *.srg (archivos de polilínea)

» *.msr (archivos en formato MineSight Resource), utilizado para contener datos de objetos geométricos (cadenas, superficies, sólidos).Tradicionalmente, los modelos de bloques de MineSight han utilizado un sistema de modelado de bloques completos (tamaños de bloques fijos sin subceldas) con elementos del modelo que identifican los porcentajes del bloque dentro de los contactos del dominio geológico. La mayoría de los modelos MineSight encontrados seguirán siendo de este tipo. Este enfoque permitió modelar minas muy grandes dentro de las limitaciones de memoria y almacenamiento del pasado y, por lo tanto, fue popular entre las minas grandes (y durante muchos años, la única forma en que las minas grandes podían tener un modelo de bloque único que cubriera todo su sitio).

Desde 2013, MineSight ofrece subbloqueo (sub-celda) que genera un archivo adicional asociado con el modelo de bloque 3D que solo se aplica a áreas y elementos subbloqueados.GEMS

Los archivos de modelo de bloques de Geovia GEMS tendrán el sufijo *.txt. GEMS utiliza un enfoque de modelo de porcentaje parcial sin subceldas.

MICROMINE

Un modelo de bloques de Micromine tendrá el sufijo *.dat (el mismo que los archivos MineSight).

-

Explorando las Unidades de Metales Preciosos: De Onzas Troy a Quilates y Más

Unidades de metales preciosos

Los metales preciosos se pesan en onzas troy (oz), pero el prefijo «troy» generalmente se omite:

- 1 onza troy = 31.103 g

- 1 onza troy se subdivide en 20 pesos (abreviado dwt)

- 1 peso = 1.555 g

- 1 peso se subdivide en 24 granos (abreviado gr)

- 1 grano = 0.0648 g

En lugar de pesos, la literatura antigua a menudo solo se refiere a pesos, por ejemplo, «el mineral tenía 3 pesos por tonelada larga». Esto debería leerse como «el mineral tenía 3 pesos troy por tonelada larga». En términos métricos, esto sería 4.6 g/t.

Nota: Dos errores comunes al convertir las calidades de metales preciosos son:

- Se confunde la onza troy de metal precioso (onza troy a 31.103 g) con la onza de peso normal (onza avoirdupois) a 28.350 g.

- La abreviatura gr para grano se confunde fácilmente con g para gramo, lo que resulta en una multiplicación involuntaria por el factor 15.4.

La proporción de oro puro en una amalgama a menudo se expresa en términos de «fineness» o partes por 1,000. El oro puro es 1,000 fine. También se utiliza la unidad quilate. 24 quilates equivalen al 100% de oro o un «fineness» de 1,000. Correspondientemente, 12 quilates equivalen al 50% de oro o un «fineness» de 500.

Una unidad frecuentemente utilizada en conexión con metales preciosos, especialmente en ensayos de oro, es la «assay ton*» (o tonelada métrica de ensayo). Esta unidad designa la masa de muestras individuales que se van a ensayar. Se remonta a tiempos previos al procesamiento de datos, cuando los químicos de ensayo preferían trabajar con cantidades que indicaran en cifras convenientes la calidad deseada, en este caso, 1 onza/tonelada corta, sin necesidad de conversiones prolongadas.

Una tonelada de ensayo (o tonelada métrica de ensayo) equivale a un peso de muestra de ensayo de aproximadamente 30 g. (La cantidad exacta es 907.2/31.103 = 29.17 g. Relacionado con la tonelada métrica, esto sería 1,000/31.103 = 32.15 g.)

Bajo ciertas circunstancias de calidad, es necesario utilizar muestras con al menos una tonelada de ensayo, a veces incluso hasta dos toneladas de ensayo, para obtener ensayos significativos de metales preciosos. Hay reglas prácticas simples para elegir el tamaño de la muestra. Sin embargo, es más aconsejable calcular el peso de la muestra mediante métodos estadísticos, teniendo en cuenta el tamaño de las partículas de oro y la calidad esperada de oro (ver, por ejemplo, Clifton et al. 1969, también Wellmer 1998, Stat. Eval., p. 101ff).

Finalmente, debe mencionarse una unidad adicional de peso de metales preciosos que tiene una cierta importancia regional. A través de los comerciantes indios, la unidad «tola» se extendió desde la India hasta el este y sur de África: 1 tola = 11.6638 g. Una unidad que encontramos con frecuencia al evaluar depósitos es 1 unidad en concentrados. Una «unidad» (abreviada como 1 u) siempre es el 1% del metal contenido en el concentrado. Hoy en día, la mayoría de los precios se refieren a toneladas métricas, es decir, 1 unidad = 10 kg. Sin embargo, solían referirse a toneladas largas: 1 unidad = 22.4 libras = 10.16 kg. En el caso de toneladas cortas: 1 unidad = 20 libras = 9.07 kg. La abreviatura para 1 tonelada métrica de unidad es a veces «m.t.u.»

Unidades Especiales de Masa

a. Para las gemas, también se utiliza la unidad «quilate», pero en un sentido diferente que con metales preciosos (ver Sección 1.1.4) porque es, en este caso especial, una unidad absoluta:

- 1 quilate = 0.2 g

- 1 quilate se subdivide en 20 puntos (pt; 1 pt = 0.05 quilates o ct)

b. El mercurio se vende en «frascos», 1 frasco = 34.473 kg

- 1 frasco contiene 76 libras

c. El precio del estaño (Sn) de Malasia, que es de importancia internacional, hasta hace poco se cotizaba como el precio por «picul»:

- 1 picul = 60.47899 kg

*Un assay ton es una unidad de peso de mineral que se utiliza para el análisis. Equivale a 29166²/₃ miligramos. El número de miligramos de metal precioso en esta cantidad de mineral es igual al número de onzas troy por cada 2000 libras.

El assay ton se utiliza para expresar el rendimiento esperado de metal precioso a partir de un mineral. El símbolo del assay ton es AT.

La palabra assay ton se formó en inglés en los años 1880. El primer uso conocido del término fue en 1881, en Transactions of American Institute of Mining Engineers 1880–1

Descargar Tabla de conversion entre medidas de masa y equivalencias

-

La Importancia del Aseguramiento y Control de Calidad en la Estimación de Recursos

Introducción: La estimación de recursos es un proceso delicado y complejo, similar a un “castillo de naipes”. Cada etapa del proceso, desde el muestreo y la observación geológica hasta la geoestática y el modelado de recursos, es crucial para el resultado final. Este artículo explora la importancia del Aseguramiento y Control de Calidad (QA-QC) en este proceso.

Objetivos del Aseguramiento y Control de Calidad (QA-QC): Un buen programa de QA-QC tiene tres objetivos principales. Primero, prevenir la entrada de grandes errores en la base de datos utilizada para el modelado de recursos. Esto se logra a través de una serie de controles y balances que garantizan la precisión y consistencia de los datos recopilados.

Segundo, demostrar que las discrepancias en los muestreos y análisis son pequeñas en comparación con las variaciones geológicas. Esto se logra a través de la comparación constante de los datos recopilados con los estándares conocidos y la repetición regular de las pruebas para verificar su consistencia.

Tercero, garantizar que la precisión de la información utilizada para el modelo de recursos pueda ser confirmada por otros laboratorios, ensayos metalúrgicos y, finalmente, por la producción del molino y de la mina. Esto se logra a través del uso de técnicas estadísticas rigurosas y el seguimiento constante del rendimiento del laboratorio.

El papel del QA-QC en la factibilidad: El documento de factibilidad debe incluir evidencia que respalde la validez de la información utilizada para construir el modelo de recursos. Esto incluye ensayos, geología y geotecnia. Este documento se centra en la calidad de los ensayos e incluye algunas consideraciones geológicas y geotécnicas.

Conclusión: Además de ser un requisito para producir un documento de factibilidad integral, el Aseguramiento y Control de Calidad (QA-QC) es vital para garantizar la precisión y fiabilidad de los modelos de recursos. Al implementar un programa sólido de QA-QC, las empresas mineras pueden asegurarse de que sus estimaciones de recursos sean lo más precisas posible, lo que a su vez puede llevar a una mayor eficiencia operativa y rentabilidad.

La estimación de recursos es un proceso crucial en la gestión de proyectos. Consiste en planificar y garantizar la disponibilidad de los recursos necesarios para asegurar el buen desarrollo y éxito de un proyecto1. Este proceso debe tenerse en cuenta incluso antes de que el proyecto comience1.

Un buen programa de estimación de recursos tiene tres objetivos principales:

- Prevenir la entrada de grandes errores en la base de datos utilizada para el modelado de recursos.

- Demostrar que las discrepancias en los muestreos y análisis son pequeñas en comparación con las variaciones geológicas.

- Garantizar que la precisión de la información utilizada para el modelo de recursos pueda ser confirmada por otros laboratorios, ensayos metalúrgicos y, finalmente, por la producción del molino y de la mina.

Los recursos pueden ser de varios tipos, incluyendo recursos humanos, materiales, financieros y temporales. La gestión de las cantidades de recursos necesarios, así como su optimización, son dos de los factores clave para cumplir a cabalidad con la entrega de un proyecto.

La estimación de los recursos está anclada a la gestión de un proyecto en el sentido más amplio, pues incluye diferentes aspectos relacionados con el proceso, tales como: la proyección de la duración y coste de las actividades (presupuesto provisional), la estructura de desglose de los recursos identificados por categorías (humanos, materiales, etc.), la asignación de recursos para cada actividad (según los perfiles y habilidades)

-

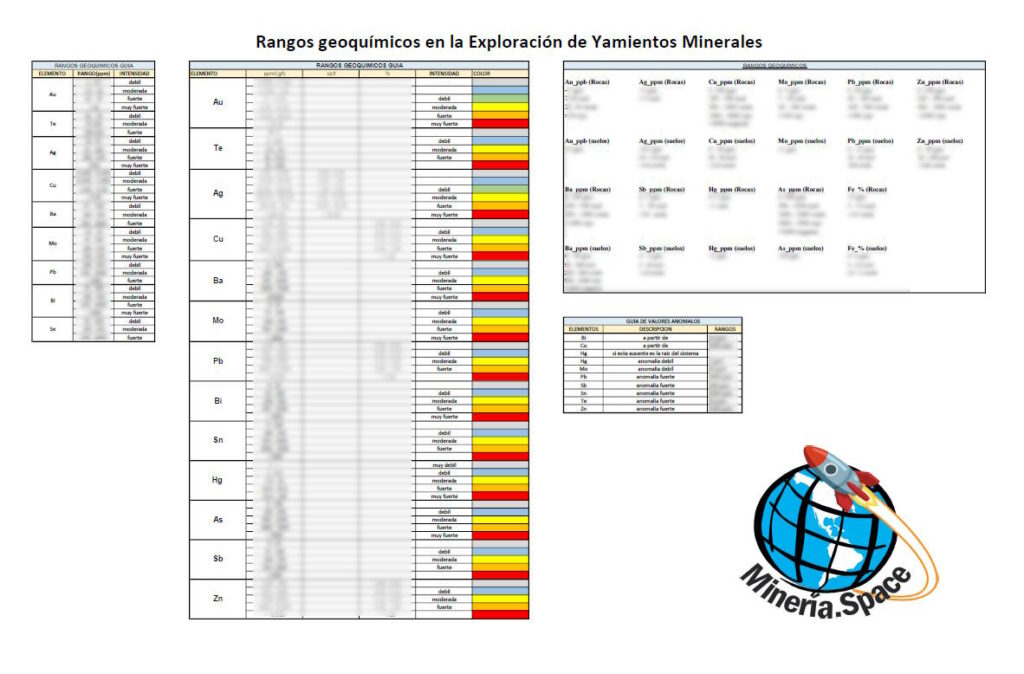

Guía de rangos geoquímicos en la Exploración de Yamientos Minerales

La exploración de yacimientos minerales es un proceso complejo que requiere de diversas técnicas para encontrar depósitos de minerales valiosos bajo la superficie terrestre. Una de estas técnicas es la geoquímica, que implica el análisis de elementos químicos en rocas, suelos, sedimentos y aguas subterráneas para identificar áreas con potencial mineral.

Para llevar a cabo la geoquímica en la exploración de yacimientos minerales, es importante tener una guía de rangos geoquímicos que permita interpretar los resultados de los análisis químicos. Esta guía proporciona valores de referencia para diferentes elementos químicos en diferentes tipos de muestras geológicas, lo que permite identificar anomalías geoquímicas que pueden estar asociadas con la presencia de depósitos minerales.

En general, los rangos geoquímicos de los elementos varían según el tipo de mineralización. Por ejemplo, los metales preciosos como el oro y la plata suelen tener rangos geoquímicos muy bajos en rocas y suelos, mientras que los metales base como el cobre, el plomo y el zinc pueden tener rangos geoquímicos más altos.

Algunos de los elementos más comúnmente analizados en la geoquímica de exploración de yacimientos minerales son el oro, la plata, el cobre, el plomo, el zinc, el níquel, el hierro y el mercurio. Los valores de referencia para estos elementos pueden variar según el tipo de muestra geológica y la región geográfica en la que se encuentran.

Por ejemplo, en el caso del oro, los valores de referencia pueden ser muy bajos en rocas y suelos, en el orden de partes por billón (ppb) o incluso partes por trillón (ppt). Sin embargo, en muestras de suelo cerca de depósitos de oro conocidos, los valores de oro pueden ser significativamente más altos, en el orden de partes por millón (ppm).

Es importante destacar que los rangos geoquímicos solo proporcionan un marco de referencia para interpretar los resultados de los análisis químicos y no deben ser utilizados como una regla estricta. Cada depósito mineral es único y puede presentar valores geoquímicos atípicos en relación a la guía de rangos. Por lo tanto, es esencial llevar a cabo una interpretación cuidadosa y detallada de los datos geoquímicos, en conjunto con otros datos geológicos y geofísicos, para identificar áreas con potencial mineral.

En resumen, la guía de rangos geoquímicos es una herramienta importante en la exploración de yacimientos minerales que permite identificar anomalías geoquímicas que pueden estar asociadas con la presencia de depósitos minerales. Sin embargo, es importante tener en cuenta que cada depósito mineral es único y puede presentar valores geoquímicos atípicos en relación a la guía de rangos. .

Descubre la lista completa de rangos geoquímicos para la exploración de yacimientos minerales en nuestra biblioteca. ¡Descarga ahora!

-

Tipos de modelos de bloques más comunes encontrados en el industria minera: Datamine.

Los tipos de modelos de bloques más comunes que se encuentran en la industria minera son Datamine, Vulcan, Surpac, Micromine y MineSight.

Los modelos de formato Datamine son actualmente el mejor formato para usar, ya que son compatibles con comandos extensos para interrogación y manipulación. Dado esto, hemos discutido este formato de archivo más extensamente que los otros formatos.

El formato Datamine estan disponibles públicamente y, por lo tanto, eran bien conocidos. Por lo tanto, muchos de los paquetes de modelado geológico admiten la exportación de sus modelos como modelos de Datamine. Otros formatos de modelos han tenido que determinarse mediante una interpretación juiciosa de prueba y error de lo que creemos que es la forma en que almacenan sus datos.

MB TIPO DATAMINE

Los modelos de bloques de Datamine se reconocerán por su sufijo: *.dm.

Hay dos limitaciones principales de los archivos Datamine que deben entenderse:

(a) Los archivos Datamine solo admiten ocho caracteres como nombres de campo.

(b) Los archivos de Datamine están limitados a un total de 256 campos (si están en el formato de precisión extendido predeterminado).

El formato Datamine tiene sus raíces en una larga historia. Datamine se fundó en 1981 y utiliza el sistema de gestión de base de datos relacional G-EXEC desarrollado por el Servicio Geológico Británico durante la década de 1970.

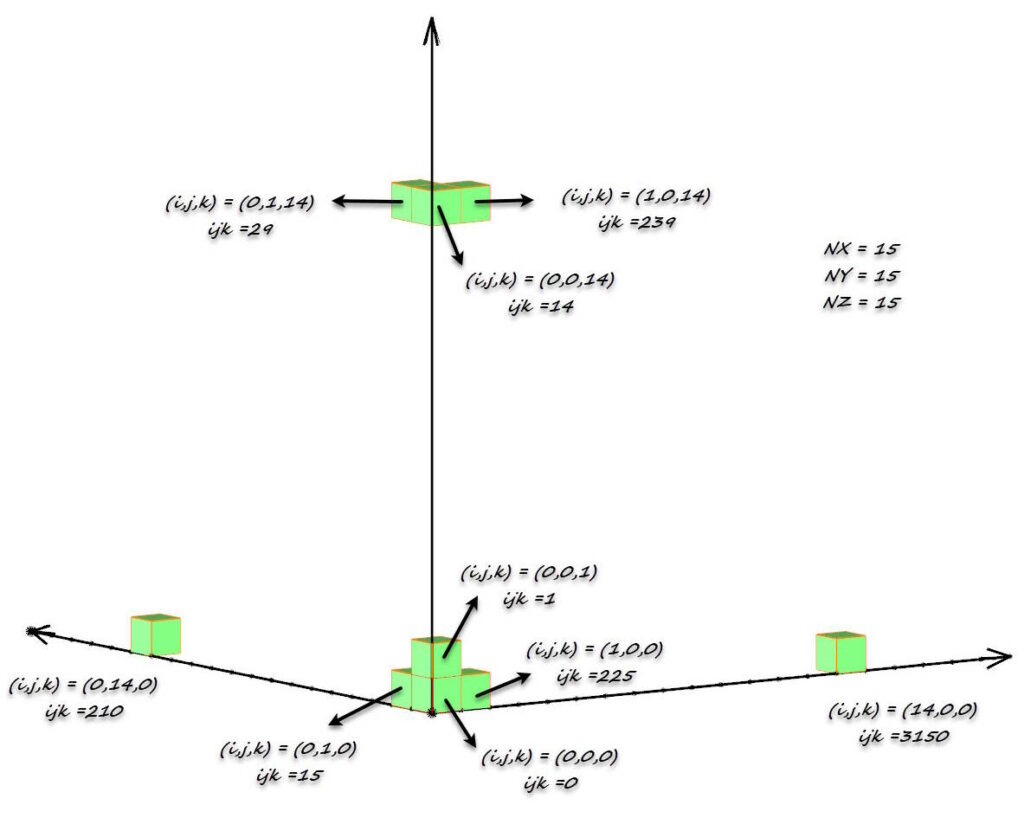

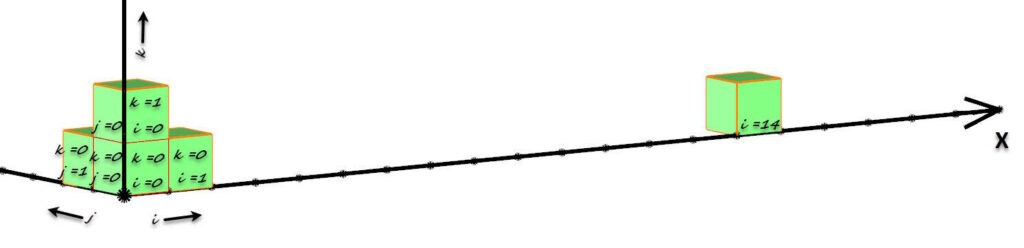

Los archivos Datamine son archivos de acceso aleatorio almacenados como tablas planas sin ninguna relación jerárquica o de red implícita. La estructura del modelo se define en un archivo de «prototipo de modelo» y el contexto espacial de cada bloque se almacena como parte del registro de cada bloque mediante posicionamiento implícito, lo que ahorra espacio de almacenamiento y tiempo de procesamiento. Esto se hace utilizando el código de indexación IJK (ver Figura 11 y Figura 12), lo que permite un acceso rápido por parte del programa de computadora a cualquier parte del modelo.

Datamine IJK schema Algunas matemáticas relacionadas con el código IJK son:

IJK = NZ × NY × I + NZ × J + K

El IJK también se puede determinar a partir del sistema de coordenadas del modelo:

I = REDONDO[ (Xc-XParentINC/2)/XParentINC]*XParentINC – XmORIG)/XParentINC

J = ROUND[ (Yc-YParentINC/2)/YParentINC]*YParentINC –YmORIG)/YParentINC

K = REDONDO[ (Zc-ZParentINC/2)/ZParentINC]*ZParentINC –

ZmORIG)/ZParentINC

Donde XParentINC, YParentINC y ZParentINC son los X, Y y tamaños Z de los bloques principales (a cualquier subcelda).

La estructura del prototipo del modelo utiliza los campos que se muestran en la siguiente tabla.

Campos Descripción XMORIG, YMORIG, ZMORIG Origen XYZ del modelo. Datamine establece el origen con respecto a la esquina de la primera celda principal y NO su centroide. XINC, YINC, ZINC Dimensiones de la celda XYZ (incrementos). NX, NY, NZ Número de celdas principales del modelo en XYZ. Datamine permite un valor de uno para el modelado de costuras. El número de celdas, en combinación con el tamaño principal de la celda, define la extensión de las dimensiones del modelo. XC, YC, ZC Coordenadas del centro de la celda XYZ. IJK Código generado y utilizado por Datamine para identificar de manera única cada posición de celda principal dentro del modelo. Las subceldas que se encuentran dentro de la misma celda principal tendrán

el mismo valor IJK.I Posición del bloque (celda) a lo largo del eje x (cero «0» para la primera posición, y aumentando por valores enteros). J Posición del bloque (celda) a lo largo del eje y (cero «0» para la primera posición, y aumentando por valores enteros). K Posición del bloque (celda) a lo largo del eje z (cero «0» para la primera posición, y aumentando por valores enteros). Datamine block model prototype structure fields

VERSIONES DEL FORMATO DATAMINE

Hay dos versiones del formato DM: precisión simple (SP) y precisión extendida (EP).

El formato DM de precisión simple original se basaba en «páginas» de 2048 bytes. (Estos son los registros de Fortran de palabras de 512 × 4 bytes). La primera página contenía la definición de datos mientras que las páginas siguientes contenían los registros de datos.

Hay dos tipos de datos: texto o alfa («A») y números de punto flotante («N»).

Los elementos enteros en la página de definición de datos se almacenan como valores Fortran REAL4 o REAL8 en los formatos de precisión simple y extendida respectivamente.

Hay algunos códigos numéricos especiales que se utilizan dentro de los datos.

-1.0 E30 = «abajo»; se utiliza como código de datos faltantes para campos numéricos, también conocido como «valor nulo». (Para los campos de texto, los datos que faltan son simplemente todos los espacios en blanco).

+1.0 E30 = «superior»; y se usa si se necesita una representación de «infinito».

+1.0 E-30 = «TR» o «DL»; se utiliza si se requiere para representar un valor de ensayo de «traza» o «por debajo del límite de detección».Todos los datos de texto se mantienen en variables REALES, no en el tipo CARÁCTER de Fortran, aunque el formato almacenado es idéntico. Esto permite el uso de una matriz REAL simple para contener un búfer de página completo y otra matriz REAL para contener la totalidad de cada registro lógico para escritura o lectura. Este concepto se originó en el sistema G-EXEC del Servicio Geológico Británico en 1972 y fue la clave de la generalidad de Datamine, en lugar de tener que predefinir formatos de datos específicos para cada combinación diferente de texto y campos numéricos.

El formato de archivo Datamine de «precisión extendida» (EP) tiene páginas dos veces más grandes que el formato de archivo de «precisión simple» (4096 bytes de longitud) y la estructura de la página simplemente se asigna a palabras de 8 bytes en lugar de palabras de 4 bytes.

El formato de archivo Datamine de «precisión simple» es efectivamente un formato heredado y, con suerte, ahora no se encontrará con frecuencia. Estos archivos solo pueden tener 64 campos, mientras que los archivos de «doble precisión» pueden tener 256 campos.

El formato de archivo EP Datamine permite el Fortran REAL*8 completo (o DOUBLE PRECISION), pero para los datos de texto solo se utilizan los primeros cuatro bytes de cada palabra de doble precisión. Por lo tanto, la estructura de archivos EP es ineficiente en términos de almacenamiento de datos para archivos que tienen cantidades significativas de datos de texto.

Los modelos de bloques de Datamine tienen dos «niveles» de bloques: bloques principales y bloques secundarios (subbloques o subceldas). Cuando se crea un modelo de Datamine, el usuario especifica el tamaño del bloque principal, que será consistente durante la vida útil del modelo.

Durante el proceso de creación de un modelo de bloques de Datamine, los subbloques se crean a lo largo de los límites para que un bloque principal pueda tener cualquier cantidad de bloques secundarios, y pueden ser de cualquier tamaño. Es posible que cada bloque principal tenga un número diferente de bloques secundarios.

DATAMINE – UNICODE

Los modelos de bloque Unicode de Datamine se reconocerán por su sufijo: *.dmu.

Una limitación importante con el formato de archivo Datamine es que almacena todo el texto en formato ASCII, que se desmorona cuando intenta trabajar en un lenguaje simbólico como ruso, polaco, japonés, chino, etc.

Tenga en cuenta que un modelo de bloque *.dmu tiene las siguientes características:- No hay límite en el tamaño del nombre del campo (solía tener ocho caracteres, ahora puede ser cualquier cosa).

- Hay soporte para cualquier idioma, codificado directamente en el archivo.

- Todavía hay un límite estricto de 256 campos, pero ahora su campo de texto solo cuenta para uno de esos campos. Anteriormente, si su columna de texto tenía un ancho de 20, contaría como cinco campos, por lo que ahora puede comprimir más campos de manera efectiva si está usando texto.

- Hay disponibles longitudes de texto variables. Si tuviera una columna con AAAA y AAAAAAAA, necesitaría definir de antemano que la columna tiene ocho caracteres. Ahora, no le importa el número de caracteres (máximo o mínimo) que haya en una columna.

La recomendación es que probablemente no debería usar archivos *.dmu a menos que realmente tenga que hacerlo. Hay muchos más usuarios que usan archivos *.dm, por lo que es más probable encontrar y corregir cualquier error de software relacionado con los modelos de bloques para los archivos *.dm que para los archivos *.dmu.Proxima entrega: Modelo de bloques en Surpac, Vulcan, Minesight y Micromine.

-

Estimación de leyes a partir de funciones de base radial: ¿cómo se compara con la estimación geoestadística convencional?

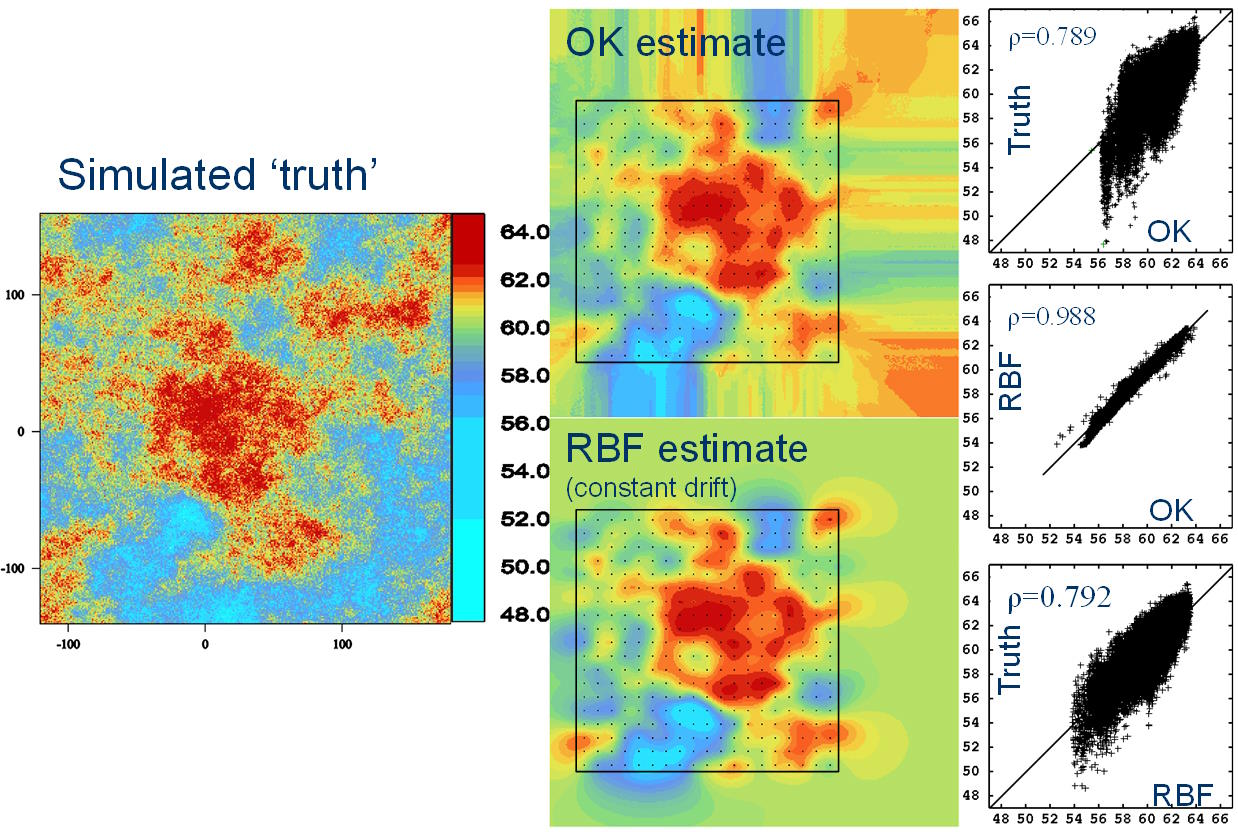

El modelado implícito es un enfoque de modelado espacial en el que la distribución de una variable objetivo se describe mediante una función matemática única que se deriva directamente de los datos subyacentes y los controles paramétricos de alto nivel especificados por el usuario. Este enfoque de modelado se puede aplicar a variables discretas como la litología (después de convertir los códigos discretos en valores numéricos) o a variables continuas como las leyes geoquímicas. Este artículo discute la estimación de variables continuas (leyes) utilizando el modelado implícito.

Uno de los motores subyacentes del modelado implícito para producir esta descripción de función matemática es la función de base radial (RBF). En esencia, la RBF es una suma ponderada de funciones posicionadas en cada punto de datos. Se resuelve un sistema de ecuaciones lineales para derivar los pesos y los coeficientes de cualquier modelo de deriva subyacente. Una vez derivada, la RBF se puede resolver para cualquier punto no muestreado o promediarse sobre cualquier volumen para proporcionar una estimación de grado. Es posible, por ejemplo, consultar la RBF en una rejilla regular para obtener una estimación de los grados de bloque. Dada la facilidad de creación de una RBF y su capacidad para predecir el grado, surge la pregunta de cómo se comparan los grados derivados de la solución de una RBF con las estimaciones de grado derivadas de métodos convencionales de interpolación geoestadística (por ejemplo, kriging ordinario (OK)).

El propósito de este artículo es describir en términos sencillos:

- • la estructura básica de una RBF

- • el papel de la elección paramétrica en la solución de las RBF y cómo esto influye en el carácter de la solución

- • las similitudes y diferencias fundamentales entre las RBF y los estimadores geoestadísticos convencionales.

Utilizando una simulación condicional de alta resolución, se muestra que en muchas situaciones, las estimaciones de la RBF y el OK son muy similares.

INTRODUCCIÓN

En los últimos años, los modelos alámbricos implícitos se han utilizado cada vez más para desarrollar formas 3D coherentes para su uso posterior en la estimación a través de métodos tradicionales (por ejemplo, kriging ordinario (OK)). Cowan et al (2003) introdujeron el término «modelado implícito» en la tarea de modelar geometrías de superficies geológicas. El modelado implícito describe un enfoque del modelado espacial en el que una combinación de datos y controles paramétricos especificados por el usuario definen una función de volumen matemática única. Este enfoque puede aplicarse al modelado de superficies a partir de variables categóricas, como la litología, o al modelado de variables continuas, como leyes geoquímicas en todo el espacio. La función más común actualmente en uso para el modelado implícito es la función de base radial (RBF). El término implícito se usa porque la superficie que se modela existe implícitamente dentro de la función de volumen como una superficie isopotencial definida por los datos en lugar de por un proceso de dibujo explícito. Esta función de volumen puede luego ser cuadriculada, o ‘renderizada’, en una estructura alámbrica para su visualización o posterior uso de modelado.

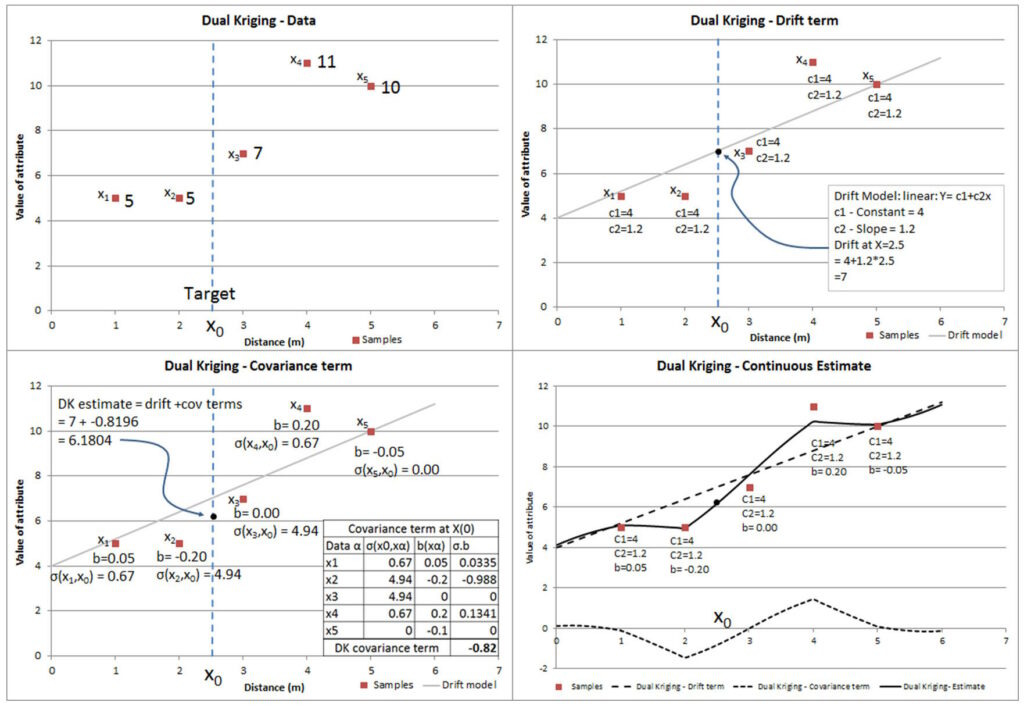

El método de modelado implícito ahora se usa ampliamente para el modelado de la geometría de la superficie a partir de datos de registro categóricos y para el modelado de «isosuperficies de grado» basadas en variables de grado continuo. Lo que muchas personas desconocen es que los modelos implícitos utilizados para generar «isosuperficies de ley» también pueden proporcionar estimaciones puntuales o de bloque de la ley. En muchas situaciones, son muy similares a las estimaciones obtenidas con métodos de estimación más familiares, como OK. Hay una razón para esto: se puede demostrar (Carr et al, 2001; Chiles y Delfiner, 1999; Costa, Pronzato y Thierry, 1999) que el RBF es matemáticamente equivalente a una formulación particular de kriging (kriging dual (DK) ). En la práctica, las estimaciones derivadas de los RBF también suelen ser muy similares a las producidas por OK.

El propósito de este documento es describir (en términos simples) la estructura básica de un RBF e ilustrar las similitudes que tiene con el kriging. También discutiremos brevemente el papel de la elección de parámetros en la solución de RBF y mostraremos cómo esto influye en el carácter de la solución.

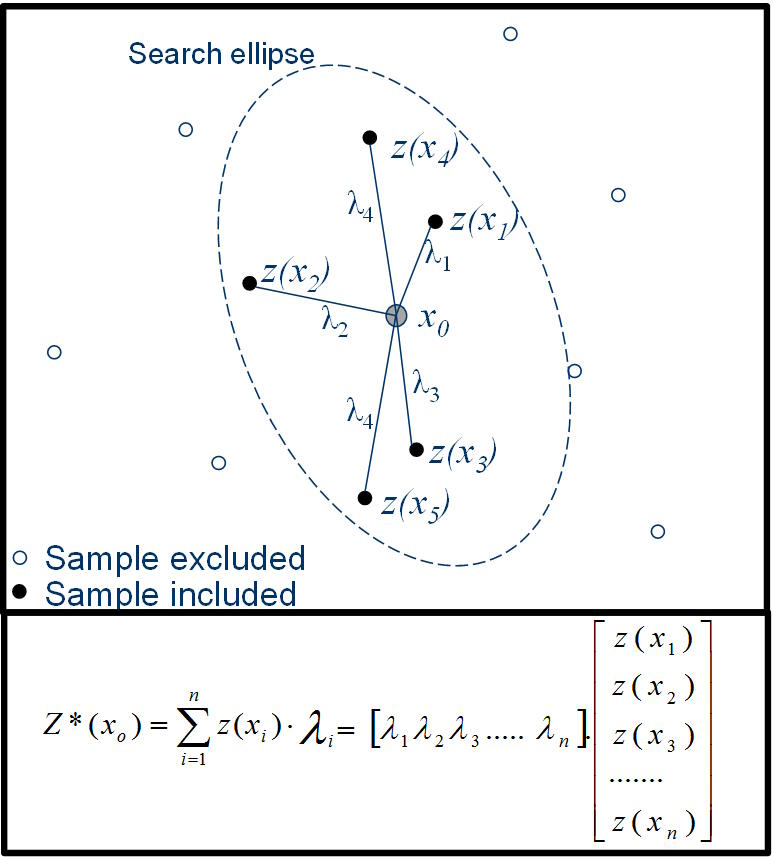

LA IDEA DE LA INTERPOLACIÓN

La interpolación es el proceso de predecir (estimar) el valor de un atributo en una ubicación no muestreada a partir de mediciones del atributo realizadas en los sitios circundantes (Figura 1). En la interpolación lineal, la calificación en la ubicación objetivo se calcula como un promedio lineal ponderado de los datos de la muestra. Diferentes interpoladores usan diferentes métodos para determinar el valor de los pesos.

Cuando el punto a estimar está dentro del campo de datos disponibles, el proceso se denomina interpolación; cuando el punto está fuera del campo de datos, el proceso se denomina extrapolación. Este proceso puede realizarse en una, dos, tres o cuatro dimensiones. Por lo general, en la estimación de recursos minerales, nos preocupamos por problemas prácticos tridimensionales: predecir la ley de un atributo (por ejemplo, una ley de metal) en ubicaciones no muestreadas a partir de valores medidos en muestras de perforación dispersas. Es una suposición subyacente que el atributo que intentamos predecir es espacialmente continuo, que toma un valor real en todas las ubicaciones posibles. Hay muchas formas diferentes de interpolador posibles. El más básico es el método constante por partes, más conocido como estimación del vecino más cercano, en el que cualquier ubicación no muestreada simplemente toma el valor del punto de datos más cercano. El estimador continuo resultante toma la forma de un patrón de mosaico, con parches de ley constante separados por pasos repentinos. Esta no es una representación muy realista de la forma en que se observa que los atributos reales, como las leyes del metal, varían en la práctica, y otorga pesos significativamente diferentes a las muestras en los extremos espaciales del conjunto de datos. En aras de la simplicidad en la discusión, este documento considerará que el atributo que se predice es el grado de un metal, sin embargo, la idea puede extenderse simplemente a cualquier variable continua.

El interpolador kriging (local)

Los interpoladores se dividen en dos tipos generales: globales o locales. Un interpolador global tiene en cuenta todos los puntos conocidos para estimar un valor, mientras que la interpolación local utiliza un subconjunto de datos, generalmente definido por una vecindad de búsqueda centrada en el punto que se estima.

El interpolador que probablemente se usa más comúnmente en minería es kriging, o más particularmente OK. La idea general es sencilla: la estimación de un punto se basa en una combinación lineal ponderada de valores de datos locales, y los pesos se calculan de tal manera que se minimiza la varianza del error en función de un modelo asumido para la covarianza espacial. Kriging se basa en una serie de suposiciones clave:

- La suposición subyacente es que las observaciones de la muestra se interpretan como los resultados de un proceso aleatorio. La variable en estudio (por ejemplo, grado de Fe

s) se puede describir mediante una función aleatoria matemática. Esta conceptualización de los datos es simplemente un ingenioso truco que nos permite describir la realidad como el resultado de un modelo probabilístico.